Uno de los anuncios más interesantes en el mundo NiFi ha sido el de Cloudera teniendo NiFi como una función. Es decir, poder subir un flujo y que ese se ejecute bajo demanda, permitiéndole ejecutar flujos de NiFi en clústeres de Kubernetes (K8S).

Esta opción es más rentable, se escala de manera eficiente (hacia arriba y hacia abajo), y proporciona aislamiento de recursos. Esto último por lo general, puede ser un desafío en un clúster multitentant con "vecinos ruidosos" (entendido como aquellas cargas que se llevan todos los recursos cada vez que corren).

Funciones como servicio

Las Funciones como servicio (FaaS) es una categoría de servicios en la nube que ofrecen todos los principales proveedores nube (AWS Lambda, Azure Functions, Google Cloud Functions, etc.).

Estos servicios permiten a los clientes ejecutar microaplicaciones que se activan bajo eventos específicos sin la complejidad de construir y mantener la arquitectura asociada.

Por serverless se entiendeque los recursos se aprovisionan y mantienen unicamente cuando la aplicación procesa los datos. De esta manera, no se necesita ningún recurso en constante funcionamiento. Esta es la forma más rentable de ejecutar aplicaciones que solo necesitan ejecutarse después de algunos desencadenantes.

Las funciones como servicio también proporcionan un escalado prácticamente ilimitado y puede ser una muy buena opción para manejar casos de uso que se ejecutan bajo eventos.

DataFlow Functions

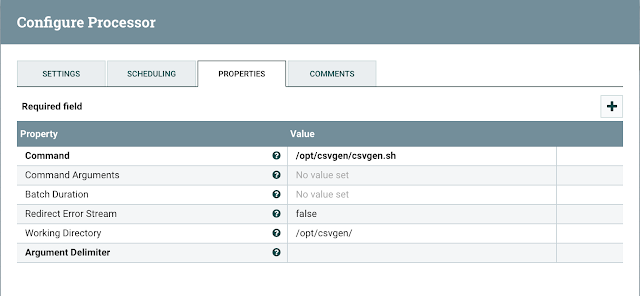

DataFlow Functions habilita Apache NiFi como la primera interfaz de usuario sin código para crear y ejecutar funciones de manera muy eficiente. DataFlow Functions, con tecnología de Apache NiFi, es la opción más eficiente para ejecutar flujos controlados por eventos para una amplia gama de casos de uso comunes.

Algunos de los posibles casos de uso incluyen:

- Procesamiento en tiempo real de archivos mientras estos aterrizan en un almacén de objetos

- Integración de servicios de terceros y API para exponer microservicios

- Procesar flujos de datos, para IoT, ciberseguridad, detección de fraude y más.

- Integrar con backends móviles